지식 노동자 (대학원생, 교수, 의사, 애널리스트, 변리사, 컨설팅)의 종말의 시작? 전화 40년, 인터넷 10-15년 사이 대중에게 채택; 인공지능은 인터넷 정도의 스피드로 확산될 것

딥리서치가 작성한 엔비디아 투자 보고서

https://blog.naver.com/mynameisdj/223...

유펜 Ethan Mollick 교수님의 글

https://www.oneusefulthing.org/p/the-...

https://www.youtube.com/watch?v=8TyjphM8wcg

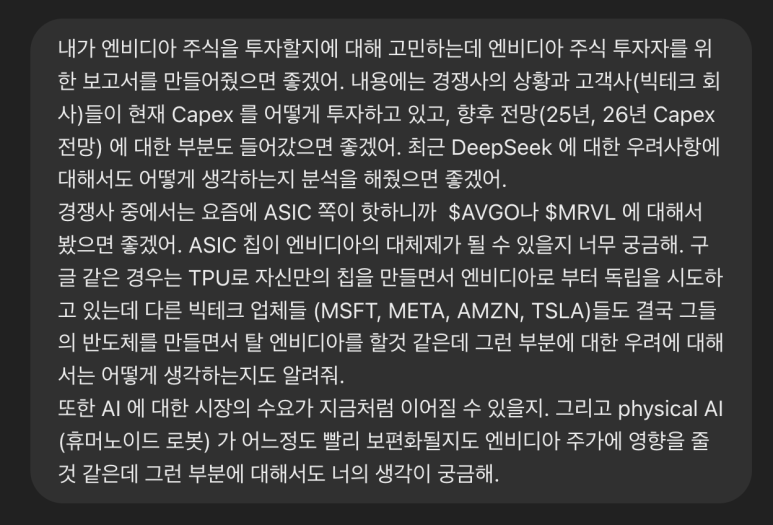

OpenAI Deep Research 에게 엔비디아에 대한 리서치를 해달라고 했습니다.

Deep Research 의 파괴력에 대해 보여드리고 싶어서 먼저 공유합니다.

자세한 내용은 유튜브에 올라올 예정입니다.

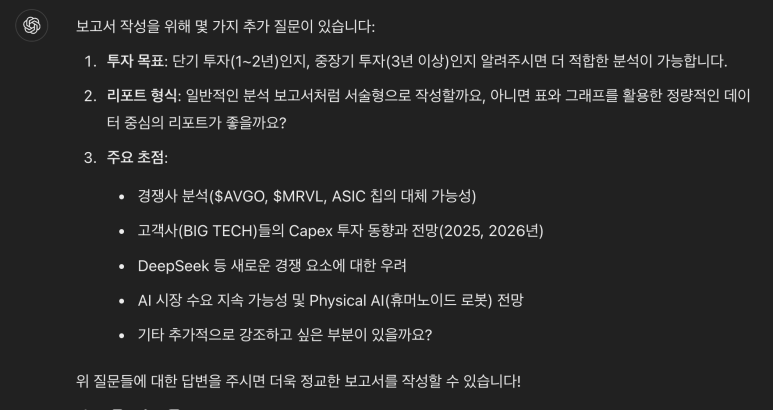

프롬프트는 아래와 같습니다.

이렇게 한두번 주고 받고

정말 결과를 만들어내고 있습니다.

13분 뒤에 결과가 나왔습니다.

결과를 보시기 전에 한마디만 드리면

'너프된 모델'이 만들어낸 결과입니다.

o3-mini 모델로 deep research 를 사용했습니다.

o1-pro로 맡기면 더욱 결과가 좋다고 하던데

(제가 o1 pro 로 돌린 deep research 의 결과는 20시간째 결과를 기다리고 있어서 그건 당장 공유는 못하겠네요.)

일단 급한대로 o3-mini 로 결과를 보여드립니다.

제가 글을 보고 받은 느낌은

제가 이 정도 퀄리티의 글은 쓸 수 없다는 것이었습니다.

이미 AGI 가 왔다고 할 수 있지 않을까요?

AGI 의 정의는 사람마다 다르겠지만 저는 AGI가 왔다고 생각합니다.

엔비디아($NVDA) 투자 분석 보고서

1. 경쟁사 분석: 브로드컴, 마벨 그리고 ASIC 칩의 대체 가능성

현재 엔비디아는 고성능 AI 가속기 시장에서 압도적인 점유율을 차지하고 있으며, 약 90%에 달하는 시장을 장악하고 있습니다. 이는 데이터센터용 AI 훈련 칩 시장에서 엔비디아 GPU가 사실상 업계 표준으로 자리매김했음을 보여줍니다. 특히 엔비디아의 최신 H100 GPU는 2023년 AI 개발 분야에서 98%의 시장 점유율을 기록하며 널리 사용되었고, 차세대 Blackwell 아키텍처 출시를 앞두고 있습니다.

하지만 경쟁 환경 또한 간과할 수 없습니다. 전통적으로 네트워킹 및 통신용 반도체 분야에서 강세를 보여온 브로드컴($AVGO)은 최근 대형 고객사들의 맞춤형 ASIC 수요 증가에 힘입어 AI 칩 시장에서 빠르게 성장하고 있습니다. 브로드컴은 2024 회계연도에 AI 관련 매출로 122억 달러를 기록했는데, 이는 전년 대비 220%나 증가한 수치입니다. 브로드컴 경영진은 오픈AI, 애플 등과 AI 추론 칩 개발 계약을 체결했다고 밝혔으며, 이러한 맞춤형 칩(XPU) 사업 기회를 2027년까지 600억~900억 달러 규모로 전망하고 있습니다. 실제로 브로드컴의 주가는 AI 특수를 타고 시가총액 1조 달러를 돌파하기도 했습니다. 브로드컴은 구글의 TPU 생산을 지원하는 등 고객 맞춤형 ASIC 설계 분야에서 뛰어난 역량을 보여주고 있으며, Morgan Stanley는 브로드컴을 커스텀 AI 칩 시장의 선두 주자로 평가하고 있습니다.

마벨($MRVL) 역시 클라우드 기업들의 주문형 칩 수요에 발맞춰 데이터센터용 맞춤형 가속기 시장에서 두각을 나타내고 있습니다. 2024년 12월, 마벨의 시가총액은 일시적으로 인텔을 넘어서기도 했는데, 이는 AI 수요 증가에 따른 실적 개선에 대한 기대감이 반영된 결과입니다. 마벨은 주요 클라우드 사업자들에게 대규모 데이터 처리를 위한 커스텀 AI 가속기와 광통신 칩을 공급하고 있으며, Morningstar는 마벨이 "대규모 AI 칩 시장 기회를 맞아 맞춤형 가속기 포트폴리오와 광통신 분야에서의 지배적인 위치를 바탕으로 성장하고 있다"고 분석했습니다. 마벨 CEO Matt Murphy는 올해 회계연도에 AI 매출 목표인 15억 달러를 초과 달성할 것으로 예상했으며, 실제로 2024년 3분기 데이터센터 부문 매출은 전년 대비 98% 증가하여 11억 달러를 기록, 전체 매출의 70% 이상을 차지했습니다. 이는 1년 전 해당 부문 비중이 약 40%였던 것에 비해 크게 증가한 수치입니다. 마벨 경영진은 "맞춤형 프로세싱 사업이 엔비디아를 잠재적으로 교란할 수 있을 것"이라 언급하며 커스텀 칩 사업에 대한 강한 자신감을 드러냈습니다.

ASIC(Application-Specific Integrated Circuit, 주문형 반도체) 칩의 잠재적인 대체 위험 또한 주목해야 할 부분입니다. ASIC은 특정 워크로드에 최적화된 칩으로, 클라우드 기업들이 자체 수요에 맞춰 설계하여 비용 대비 성능을 높일 수 있는 대안입니다. Morgan Stanley에 따르면 ASIC 시장 규모는 내년에 거의 두 배인 220억 달러로 성장할 것으로 전망되며, 이 중 상당 부분은 아마존 AWS의 Trainium AI 칩과 구글의 TPU(Tensor Processing Unit)가 견인할 것으로 예상됩니다. 브로드컴과 마벨은 이러한 ASIC 설계 및 제조 분야에서 괄목할 만한 성과를 내고 있으며, Alchip, 미디어텍 등 아시아 업체들도 시장에 진입하고 있습니다.

하지만 ASIC이 엔비디아 GPU를 완전히 대체할 가능성은 낮다는 것이 일반적인 시각입니다. 엔비디아의 범용 GPU는 여전히 다양한 AI 작업에 유연하게 활용될 수 있으며, AMD의 GPU와 함께 멀티 퍼포즈 칩으로서 AI 칩 시장의 주류 지위를 장기적으로 유지할 것으로 전망됩니다. 실제로 분석가들은 "ASIC이 GPU를 따라잡으려면 개발 속도가 훨씬 빨라져야 할 것"이라고 지적하며, 신제품 개발 속도와 소프트웨어 생태계 측면에서 엔비디아의 우위를 강조합니다. 또한 엔비디아의 막대한 R&D 투자는 경쟁사들이 쉽게 따라 하기 어렵다는 평가를 받고 있습니다. 결과적으로 ASIC의 부상으로 클라우드 기업들이 엔비디아와의 협상력을 높일 수는 있겠지만, 엔비디아 GPU를 완전히 대체하기보다는 일부 보완재 역할을 할 가능성이 높습니다. 엔비디아 역시 Mellanox 인수를 통해 DPU(데이터 처리 장치)와 네트워킹 솔루션을 제공하며 자체 플랫폼 경쟁력을 강화하고 있습니다.

주: 엔비디아의 시장 점유율은 고성능 AI 훈련용 가속기 기준. 브로드컴/마벨의 시장 점유율은 커스텀 ASIC 분야 점유 추정.

2. 빅테크 Capex 동향 및 자체 칩 개발 전망 (2025~2026년)

엔비디아의 수요를 결정짓는 중요한 요인 중 하나는 글로벌 빅테크 기업들의 자본 지출(Capex) 동향입니다. 마이크로소프트, 메타, 아마존, 테슬라 등 주요 기업들은 AI 인프라 확보를 위해 막대한 투자 계획을 발표한 바 있습니다. 동시에 반도체 독립을 목표로 자체 칩 개발에도 적극적으로 나서고 있어, 엔비디아에 대한 의존도 변화를 면밀히 주시해야 합니다.

빅테크 Capex 투자의 급증

마이크로소프트(MSFT)의 2024년 회계연도(2023년 기준) Capex는 557억 달러에 달했으며, AI 수요에 대응하기 위해 2025 회계연도에는 약 800억 달러를 데이터센터에 투자할 계획입니다. 이는 전년 대비 44% 증가한 규모로, AI 클라우드 인프라(Azure) 확충에 집중하고 있음을 보여줍니다.

아마존(AMZN)의 2024년 자본 지출은 약 750억 달러 수준으로 추정되며, 2025년에는 이보다 더 많은 투자를 예고했습니다. Morgan Stanley는 2025년에 아마존이 964억 달러까지 투자할 것으로 전망하기도 했습니다. AWS는 AI 서버 증설 및 네트워크 인프라에 대규모 투자를 진행 중입니다.

알파벳(GOOGL), 즉 구글의 모회사는 2024년에 500억 달러 이상을 Capex에 지출했으며, 2025년에는 약 626억 달러까지 늘릴 것으로 예상됩니다. 구글은 AI 서버팜 증설뿐만 아니라 데이터센터 효율성 향상(액침 냉각 등)에도 투자를 확대하고 있습니다.

메타플랫폼스(META)는 2024년 추정 Capex 380억 ~ 400억 달러에서 2025년에는 600억 ~ 650억 달러로 대폭 확대할 계획을 발표했습니다. 이는 전년 대비 60% 이상 증가한 수준으로, CEO 마크 저커버그는 "올해를 AI의 결정적인 해로 만들겠다"며 AI 인프라 투자를 공격적으로 늘리고 있습니다. 메타는 엔비디아 H100 GPU 약 130만 개를 올해 말까지 확보하여 자체 AI 클러스터를 구축하겠다고 밝혔습니다.

전통적으로 제조 설비 투자가 주를 이루던 테슬라(TSLA) 역시 2024년에 AI 인프라에 110억 달러 이상을 지출하며, 자율 주행(AI 훈련) 슈퍼컴퓨터 Dojo와 데이터센터 구축에 투자를 집중하고 있습니다. 일론 머스크는 "테슬라는 사실상 AI 컴퓨팅 기업"이라고 강조하며, 향후 AI 훈련 능력 확보가 자동차 사업만큼 중요하다고 언급했습니다.

이처럼 주요 빅테크 기업들의 Capex 증가는 곧 엔비디아 GPU에 대한 막대한 수요 증가로 이어집니다. 실제로 2023년 한 해 동안 엔비디아의 H100 GPU는 품귀 현상을 빚을 정도로 폭발적인 주문이 쏟아졌습니다. Morgan Stanley는 2025년 1분기에 엔비디아가 차세대 Blackwell(GH200/BG200) GPU를 최대 80만 개 출하할 수 있다고 전망하며, 이를 위한 고객사들의 예산 투입을 반영하고 있습니다. 각 GPU 가격이 6만~10만 달러 수준인 점을 감안하면, AI 인프라에 수십조 원대의 지출이 지속될 것으로 예상됩니다.

[주요 빅테크 Capex 및 자체 칩 개발 현황 표]

주: 2024년 수치는 기업 가이던스 및 보도 기반 추정, 2025년 수치는 기업 발표 또는 증권사 전망치.

자체 칩 개발로 인한 엔비디아 의존도 감소 가능성

위 표에서 볼 수 있듯이, 빅테크 기업들은 자체적인 전략적 칩 개발에 박차를 가하거나 외부 파트너와의 협력을 통해 공동 개발을 진행하고 있습니다. 이러한 움직임은 엔비디아에 대한 의존도를 낮추고 비용을 절감하려는 목적이 큽니다.

AWS는 자체 Trainium(AI 훈련용)과 Inferentia(추론 가속용) 칩을 개발하여 일부 워크로드에 적용했습니다. Morgan Stanley 분석에 따르면, 2024~25년 ASIC 시장 성장의 상당 부분은 AWS의 Trainium 도입에 기인합니다. AWS가 자체 칩 사용을 늘릴수록 엔비디아 GPU 수요의 일부를 대체할 수 있습니다.

구글은 2010년대 중반부터 TPU를 개발해 왔으며, 현재 v4를 거쳐 차세대 TPU(v5)를 테스트 중입니다. TPU는 딥러닝 추론에서 높은 효율성을 보이며, 구글은 브로드컴과 협력하여 TPU를 생산하고 있습니다. 구글이 자체 칩으로 대부분의 수요를 충당하게 되면 엔비디아에 대한 의존도는 줄어들 수 있지만, TPU는 주로 내부 사용에 한정되어 있고 엔비디아 GPU는 타사 클라우드 서비스에도 판매되는 차이가 있습니다.

마이크로소프트와 메타 또한 최근 자체 AI 가속기 개발을 추진하고 있습니다. 마이크로소프트는 AMD와 협력하여 Azure용 GPU 대안을 모색하고 있으며, 별도로 "Athena"라는 코드명의 자체 AI 칩 프로젝트에 투자하고 있는 것으로 알려져 있습니다. 메타는 한때 TPU와 유사한 MTIA(Meta Training/Inference Accelerator) 개발을 진행했으나, 성능 문제로 인해 재검토되었다는 보도가 있었습니다. 현재 메타는 엔비디아 GPU를 대량으로 구매하면서도, 향후 반도체 독립을 완전히 포기하지는 않은 상황입니다.

테슬라의 경우, 완전 자율 주행 FSD를 위한 차량용 AI 칩(FSD 컴퓨터)을 자체 개발했고, AI 훈련을 위한 Dojo 슈퍼컴퓨터용 D1 칩을 설계하여 일부 자체 클러스터에 도입하기 시작했습니다. 일론 머스크는 Dojo가 성과를 거두면 약 70억 달러 상당의 GPU 구매를 대체할 수 있다고 언급한 바 있습니다. 그러나 현재까지 테슬라는 엔비디아 GPU(A100 등)도 병행하여 활용하고 있으며, Dojo는 단계적으로 확대 적용될 예정입니다.

엔비디아 의존도 감소 효과: 이러한 자체 칩 개발 노력으로 인해 엔비디아 GPU 수요의 일부가 대체되는 것은 분명한 흐름입니다. 2024년 현재 엔비디아의 주요 고객 중 하나인 오픈AI조차도 연산 비용 절감을 위해 맞춤형 칩 개발을 고려하고 있다는 소문이 있으며, 바이트댄스(틱톡 모회사) 등도 브로드컴과 칩을 공동 개발 중인 것으로 알려져 있습니다. 이처럼 "특정 공급업체에 대한 의존은 바람직하지 않다"는 인식이 대형 기술 기업들 사이에서 확산되면서, 여러 기업들이 자체 칩 개발에 적극적으로 나서고 있습니다.

하지만 자체 칩 개발의 어려움 또한 간과할 수 없습니다. 실리콘 분야 전문 인력과 IP가 부족한 기업들은 브로드컴과 같은 파트너에 의존해야 하며, 개발 주기가 길기 때문에 단기간에 엔비디아 GPU를 완전히 대체하기는 어렵습니다. 따라서 2025~2026년 단기적으로는 엔비디아에 대한 수요가 견고하게 유지될 것으로 예상됩니다. 오히려 빅테크 기업들의 공격적인 Capex 투자는 엔비디아 실적에 긍정적인 모멘텀으로 작용할 가능성이 큽니다. 다만 중장기적으로는 클라우드 업체들의 협상력 강화로 인해 엔비디아가 가격 결정력 측면에서 일부 양보하거나 마진 압박을 받을 수 있습니다. 이미 AWS, MS, 구글 등의 자체 칩 개발 시도는 엔비디아 GPU 공급 가격 인하 압박 카드로 활용되고 있습니다.

요약하자면, 2025~2026년 빅테크 기업들의 Capex 증가는 엔비디아 GPU 수요를 단기적으로 견인하는 긍정적인 요인입니다. 그러나 동시에 자체 칩 개발이라는 구조적인 흐름이 진행되고 있으므로, 엔비디아는 경쟁 우위 유지(더욱 뛰어난 차세대 GPU 공급)와 고객 관계 관리(가격 및 공급 협상)에 더욱 힘써야 할 것입니다.

3. DeepSeek 이슈: AI 모델 효율성 향상의 영향

최근 AI 업계에서는 모델 효율성의 급격한 향상이 엔비디아에 미칠 영향에 대한 논의가 활발하게 이루어지고 있습니다. 특히 중국 스타트업이 개발한 DeepSeek 모델의 등장은 이러한 논쟁에 불을 지폈습니다. DeepSeek-R1이라는 AI 챗봇 모델은 OpenAI의 최신 모델과 견줄 만한 성능을 보이면서도, 훈련 비용과 GPU 자원을 크게 절감했다고 주장하며 업계의 주목을 받았습니다.

DeepSeek의 성능과 효율성

DeepSeek 개발팀에 따르면, 이 모델은 GPU 메모리 사용량을 75% 절감하고 속도를 2배 향상시켰으며, API 사용 비용을 95%까지 낮추는 혁신적인 성과를 달성했습니다. 실제로 DeepSeek는 단 2,048개의 NVIDIA H800 GPU로 약 278만 8천 GPU 시간을 사용하여 모델을 훈련했다고 발표했는데, 이는 비용으로 환산하면 약 560만 달러 수준에 불과합니다. 반면, OpenAI의 GPT-4와 같은 기존의 초대규모 모델은 수억 달러 이상의 훈련 비용과 수만 개의 GPU를 필요로 한 것으로 알려져 있습니다. DeepSeek는 이러한 저비용 고효율 접근 방식을 통해 2025년 1월 출시 직후 미국 iOS 앱스토어 다운로드 1위를 기록하며 ChatGPT를 제치고 업계에 큰 파장을 일으켰습니다.

엔비디아 주가에 미친 충격: DeepSeek-R1의 등장은 투자자들 사이에서 AI 수요 정점론, 즉 GPU 수요가 최고점을 찍고 감소할 수 있다는 우려를 불러일으켰습니다. 2025년 1월 27일 DeepSeek 무료 챗봇이 공개되자마자 엔비디아 주가는 하루 만에 17% 폭락하며 시가총액 5,930억 달러(약 850조 원)가 증발하는 기록적인 일일 손실을 기록했습니다. 이는 월가 역사상 최대 규모의 단일 시총 증발 사례였습니다. 같은 날 브로드컴도 17.4%, 마벨은 19.1% 급락하는 등 AI 관련주 전반에 걸쳐 "DeepSeek 충격"이 나타났습니다. 투자자들은 "이처럼 효율적인 모델이 등장한다면, 더 이상 많은 GPU가 필요하지 않게 되는 것이 아니냐"는 우려를 나타냈습니다. 실제로 애널리스트들은 "만약 DeepSeek이 더 나은 해결책이라면, AI 붐의 근본적인 기반을 흔들 수 있다. 이는 칩 수요 감소, 데이터센터 전력 증설 불필요, 대규모 데이터센터 수요 축소로 이어질 수 있다"고 분석했습니다.

DeepSeek의 한계와 논란: 하지만 DeepSeek에 대한 의구심 또한 존재합니다. 모델 공개 직후 폭발적인 수요로 인해 신규 가입이 일시 중단될 정도로 서비스 안정성 문제가 발생했으며, 모델 개발 과정에서 기존 오픈소스 및 타 모델 지식을 활용한 점(Test-Time Scaling 기법) 등 기술적인 논란도 있습니다. 또한 중국산 서비스라는 점에서 개인 정보 수집에 대한 우려(사용자 데이터 과다 수집 및 중국 서버 저장)가 제기되며 규제 이슈로까지 번지고 있습니다. 심지어 미국 정부는 DeepSeek 개발팀이 미국의 대중 수출 통제를 우회하여 NVIDIA H800 GPU를 싱가포르를 통해 밀수입했는지 여부를 조사 중이라는 보도도 있었습니다. 이러한 여러 요소들로 인해 DeepSeek이 지속적이고 안정적인 상용 서비스로 자리 잡을 수 있을지는 아직 불확실합니다.

엔비디아에 미치는 영향: 제본스의 역설 적용 가능성

DeepSeek 이슈를 통해 제기된 핵심 질문은 "AI 모델 효율성이 크게 향상되면 엔비디아의 성장에 위협이 될 것인가, 아니면 오히려 기회가 될 것인가?"입니다. 이 질문에 대해 두 가지 상반된 관점이 존재합니다.

1. 부정적 영향론: 모델 효율성 개선으로 인해 GPU 수요가 감소할 가능성을 우려하는 시각입니다. 앞서 언급했듯이 효율적인 알고리즘은 동일한 성능을 내는 데 필요한 연산량(및 GPU 수)을 줄여주므로, AI 인프라 투자 정점이 앞당겨질 수 있다는 것입니다. DeepSeek 사태 당시 Annex Wealth Management의 분석가는 "더 나은 모델이 등장한다면 앞으로 칩 수요가 줄어들고, 거대한 전력 인프라나 데이터센터 증설도 덜 필요할지 모른다"고 지적했습니다. 이는 엔비디아의 초호황이 지속되지 못하고 조기에 둔화될 수 있다는 가능성을 시사합니다. 또한 효율적인 모델이 보편화되면 GPU 가격 인하 압력 또한 커질 수 있습니다. 과거 GPU 채굴 수요 붕괴 시 그래픽카드 가격이 폭락했던 것처럼, AI 훈련 수요가 완만해지면 엔비디아의 고마진 제품 판매 환경이 악화될 수 있다는 논리입니다. DeepSeek 이슈로 인해 엔비디아 주가가 민감하게 반응했던 것은 시장이 이러한 위험 요소를 인지하고 있음을 보여줍니다.

2. 긍정적 영향론(제본스의 역설 시나리오): 반대로, 효율성 향상이 오히려 수요 폭발을 유도할 것이라는 낙관적인 시각도 강하게 제기되고 있습니다. 이는 제본스의 역설(Jevons Paradox)에 기반한 전망으로, 기술 진보로 자원 소모 효율성이 개선되면 오히려 사용량이 증가하여 총수요는 늘어난다는 경제학 개념입니다. 마이크로소프트 CEO 사티아 나델라는 DeepSeek 사태 이후 "제본스의 역설이 재현되었다. AI가 더 효율적이고 접근성이 좋아질수록 사용은 폭발적으로 늘어나 우리가 더 많은 것을 원하게 될 것이다"라고 언급했습니다. 실제로 단위당 AI 연산 비용이 낮아지면 중소기업이나 개발자들도 AI 활용을 늘리게 되고, AI의 보편화가 가속화되어 전체적으로 더 많은 연산 및 GPU 수요가 발생할 수 있습니다. 전 인텔 CEO 팻 겔싱어 역시 "컴퓨팅은 기체의 법칙을 따른다. 비용을 획기적으로 낮추면 시장은 그만큼 확장된다. 지금 시장이 잘못 판단하고 있다. 이러한 발전은 AI를 훨씬 더 폭넓게 보급시킬 것이다"라고 강조했습니다. 다시 말해, DeepSeek과 같은 효율성 혁신은 AI 활용 분야를 기하급수적으로 확대시켜 장기적으로 엔비디아에 더 큰 기회를 제공할 수 있다는 것입니다. 실제로 클라우드 업계에서는 "성능당 비용이 낮아지면 고객들의 AI 워크로드 채택이 폭발적으로 증가할 것"이라는 전망이 우세합니다.

엔비디아 역시 공식 입장을 통해 후자의 견해를 밝혔습니다. 엔비디아 대변인은 "DeepSeek은 훌륭한 AI 혁신이며, 테스트 타임 스케일링의 완벽한 사례"라며 "DeepSeek의 성과는 널리 이용 가능한 모델들과 컴퓨팅 자원을 활용하여 새로운 모델을 만들어낸 것을 보여준다"고 평가했습니다. 특히 DeepSeek이 사용한 H800 GPU는 엔비디아의 기존 제품이며, DeepSeek 모델의 추론과 확산에는 여전히 막대한 수의 NVIDIA GPU와 고성능 네트워킹이 필요하다고 언급했습니다. 엔비디아 측은 "새로운 기술로 각 GPU의 성능이 향상되면 전체적인 채택과 사용량이 크게 늘어나 생태계 전체에 이익이 될 것"이라는 입장을 밝혔습니다. 즉, GPU당 효율성이 증가하면 GPU 수요 총량이 증가한다는 것입니다. 실제로 DeepSeek과 같은 모델을 더 많이 서비스하려면 추론 서버 증설이 필요하고, 더 복잡한 차세대 모델 경쟁이 촉발되어 궁극적으로는 더 많은 연산 자원 수요로 이어질 것이라는 논리입니다.

결론적으로, AI 모델 효율성 향상은 단기적으로 엔비디아 주가 변동성을 키우는 위험 요인이 될 수 있지만, 장기적으로는 AI 시장 규모를 확대하는 긍정적인 요인이 될 수도 있습니다. DeepSeek 사태는 엔비디아 투자자들에게 기술 혁신 리스크를 상기시키는 계기가 되었습니다. 그러나 현재까지 DeepSeek의 사례를 살펴보면 엔비디아 생태계 위에서 혁신이 일어난 측면도 있습니다. 나델라 CEO의 언급처럼 "더 저렴하고 빨라진 AI는 활용 범위를 기하급수적으로 넓힐 수 있다"는 전망에 무게를 둔다면, 엔비디아에 대한 수요 붐은 쉽게 사그라들지 않을 것으로 예상됩니다. 이는 다음 섹션에서 다룰 AI 시장 수요 지속성과도 밀접하게 연결되는 부분입니다.

4. AI 시장 지속 가능성 및 Physical AI(휴머노이드 로봇) 보편화 전망

엔비디아의 지속적인 성장을 위해서는 현재의 AI 수요 붐이 일시적인 유행에 그치지 않고 지속 가능한 흐름으로 이어지는지 확인하는 것이 중요합니다. 또한 Physical AI, 즉 휴머노이드 로봇 분야가 차세대 성장 동력으로 부상할 가능성과 엔비디아가 이 흐름에서 어떤 역할을 담당할 수 있을지 살펴보겠습니다.

AI 인프라 수요의 지속성

현재의 AI 붐은 여러 지표에서 지속적인 성장세를 나타내고 있습니다. 데이터센터 투자의 확대와 AI 서비스의 확산은 단기적인 유행이라기보다는 구조적인 변화로 해석될 수 있습니다.

AI 데이터센터 투자 증대: 앞서 빅테크 기업들의 Capex 투자 동향에서 확인했듯이, 2024~2025년 AI 관련 설비 투자가 급증하고 있습니다. JP Morgan은 AI 데이터센터 건설 붐이 2025~2026년 미국 GDP 성장에 0.1~0.2%p 기여할 것으로 예상했습니다. 미국 내 데이터센터 수는 매년 25%씩 증가하고 있으며, 그 중 상당 부분이 AI 워크로드 처리를 위한 "AI-ready" 데이터센터로 구축되고 있습니다.

에너지 소비 지표: 국제에너지기구(IEA)는 전 세계 데이터센터의 전력 수요가 2022년 대비 2026년까지 2배로 증가할 수 있다고 전망했는데, 그 주요 원인으로 AI 채택 증가를 지목했습니다. 이는 AI 연산량이 앞으로 수년간 기하급수적으로 증가할 것이라는 점을 시사합니다. MIT는 "텍스트에서 비디오, 이미지로 AI 모델이 발전할수록 모델 규모가 커지고 에너지 소비량도 증가한다"고 분석하며, 고도화된 생성 AI와 멀티모달 AI의 등장으로 연산 수요는 더욱 증가할 것으로 예상했습니다.

글로벌 AI 시장 규모 전망: 시장 조사 기관들의 자료에 따르면, 전 세계 AI 시장 규모는 2024년 약 2,140억 달러에서 연평균 30% 이상의 높은 성장률로 확대되어 2030년에는 1.31.8조 달러에 이를 것으로 전망됩니다. PwC는 AI가 2030년까지 글로벌 GDP에 15조 달러 이상을 기여할 것으로 예측했습니다. 이처럼 AI 소프트웨어, 서비스, 하드웨어 전반에 걸쳐 장기적인 성장세가 예상됩니다. 실제로 20232024년 동안 발표된 빅테크 기업들의 실적 보고서에서는 클라우드 AI 서비스 이용량과 관련 매출이 두 자릿수 퍼센트(%)로 급증하고 있음을 확인할 수 있습니다. 예를 들어, 마이크로소프트의 Azure OpenAI 서비스 매출은 분기별 성장률이 매우 높고, 엔비디아의 데이터센터 매출 또한 2023년 한 해 동안 3배 이상 증가했습니다.

수요의 저변 확대: 2024년을 기점으로 생성형 AI가 일반 소비자와 중소기업 시장까지 확산되고 있습니다. ChatGPT API를 시작으로 다양한 오픈소스 LLM, 이미지 생성 서비스 등이 출시되면서 AI 활용 분야가 더욱 다양해졌습니다. 전 산업 분야에서 디지털 전환(DX)이 가속화되면서 AI 도입은 필수가 되었고, 정부 및 공공 부문까지 AI 인프라 투자를 늘리고 있습니다. 이러한 추세에 따라 클라우드 기업들은 엔비디아 GPU 등 AI 인프라 증설을 멈출 수 없는 상황입니다. Morgan Stanley는 "AI는 결코 일시적인 유행이 아니다. 막대한 자금이 투자되고 있다"며 AI 인프라 투자 붐이 앞으로도 수년간 지속될 것으로 전망했습니다.

요약하자면, AI 수요는 2025~2026년에도 견조한 성장세를 유지할 것으로 예상됩니다. 데이터센터 용량 증설과 AI 서비스 확산 속도가 유지된다면 엔비디아의 GPU 판매 또한 높은 수준을 지속할 가능성이 큽니다. 다만 성장률은 2023년과 같은 폭발적인 초기 급등 이후 점차 정상적인 궤도로 진입할 수 있습니다. 이는 고성장세가 지속된다는 의미이지 성장세가 꺾이는 것은 아니라는 점에서, "AI 초호황 → 거품 붕괴" 시나리오보다는 "고성장 → 안정적 성장" 시나리오에 더 무게가 실립니다. DeepSeek 사태와 같은 예기치 못한 변수가 발생하지 않는 한, AI 인프라 수요는 당분간 포화 상태에 이르지 않을 것이라는 것이 시장의 공통된 의견입니다.

Physical AI: 휴머노이드 로봇의 부상과 전망

차세대 AI 활용 분야로 Physical AI, 즉 현실 세계에서 활동하는 지능형 로봇 시장이 주목받고 있습니다. 특히 사람과 유사한 형태의 휴머노이드 로봇은 노동력 대체 및 신산업 창출 측면에서 "게임 체인저"가 될 것으로 기대를 모으고 있으며, 엔비디아를 비롯한 여러 기술 기업들이 휴머노이드 로봇 기술 개발에 적극적으로 투자하고 있습니다.

휴머노이드 로봇 개발 현황: 엔비디아, 테슬라, 아마존, 오픈AI 등 여러 기업들이 인간 형태의 로봇을 개발하거나 관련 기술에 투자하고 있습니다. 엔비디아 CEO 젠슨 황은 "AI의 다음 물결은 로봇, 그중에서도 휴머노이드 로봇이 가장 흥미로운 발전"이라고 언급하며, 2023년 말 로봇용 AI 플랫폼(Cosmos 등)을 발표하고 Isaac Sim(로봇 시뮬레이션), Jetson(엣지 AI 칩) 등 로봇 개발 전반을 지원하는 풀스택 솔루션 개발에 박차를 가하고 있습니다. 테슬라는 Optimus라는 이름의 휴머노이드 로봇 시제품을 2022년에 공개한 후, 2023~2024년에 걸쳐 자사 공장에 2대의 Optimus 로봇을 시범적으로 도입했다고 밝혔습니다. 일론 머스크는 "향후 테슬라 공장 곳곳에 수천 대의 로봇이 일하게 될 것이며, Optimus가 테슬라를 시가총액 25조 달러 기업으로 만들 수도 있다"고 언급하며 휴머노이드 로봇 사업에 대한 높은 기대감을 드러냈습니다. 미국 스타트업 Agility Robotics는 오리건주에 연간 1만 대 규모의 휴머노이드 로봇 생산 공장을 건설하고 있습니다. Figure AI, Apptronik, Sanctuary AI 등 신생 기업들도 휴머노이드 로봇 프로토타입을 개발하는 등 휴머노이드 로봇 시장은 빠르게 성장하고 있습니다. 이러한 움직임들은 2023년 ChatGPT가 소프트웨어 분야에서 일으킨 혁신을 2020년대 후반에는 로봇 하드웨어 영역에서 재현하겠다는 "로봇 분야의 ChatGPT 순간"을 만들고자 하는 업계의 열망을 반영합니다.

시장 규모 전망: 휴머노이드 로봇 시장은 아직 초기 단계로 연간 판매 대수가 매우 적지만, 향후 수십 년 동안 폭발적인 성장이 예상됩니다. Goldman Sachs는 2035년까지 휴머노이드 로봇 시장이 360억~380억 달러 규모로 성장할 것으로 전망했으며, Citi는 더 나아가 2050년경에는 7조 달러에 달하는 잠재 시장이 형성될 수 있다고 예측했습니다. 물론 2050년 전망은 매우 먼 미래이지만, 이는 인간형 로봇이 장기적으로 자동차나 스마트폰과 비견될 만큼 거대한 산업으로 성장할 수 있다는 가능성을 시사합니다. 단기적으로 2030년까지는 주로 산업용 및 물류용 이족 보행 로봇 중심으로 시장이 형성되면서 수십억 달러 규모의 시장을 형성하고, 2030년대 중반부터 서비스 및 가정용 휴머노이드 로봇 시장까지 확대되며 급성장할 것으로 예상됩니다. 즉, 향후 10년은 휴머노이드 로봇 시장의 태동기이며, 그 이후부터 본격적인 보편화 단계에 진입할 것으로 전망됩니다.

엔비디아의 역할과 기회: 엔비디아는 휴머노이드 로봇 시대에 핵심적인 역할을 수행할 준비를 하고 있습니다. 첫째, 로봇의 "두뇌"를 훈련시키는 대규모 AI 모델 학습 인프라 제공자로서의 역할입니다. 휴머노이드 로봇이 인간과 유사한 인지 및 동작 능력을 갖추려면 방대한 AI 모델(시각, 언어, 운동 제어 등)을 학습해야 하며, 이는 데이터센터에서 GPU를 활용한 훈련을 필요로 합니다. 엔비디아는 최근 TeleOp(원격 조종) 데이터 수집, 시뮬레이션, 합성 데이터 생성 등 로봇 학습 파이프라인 툴을 개발하고, 방대한 훈련 데이터를 효율적으로 생성하고 모델을 학습시키는 플랫폼을 제공하고 있습니다. 예를 들어, Apple Vision Pro를 활용하여 사람의 시연 동작을 캡처하면 Isaac Sim과 MimicGen AI를 통해 수백만 건의 가상 훈련 데이터로 증폭시키고, 이를 GR(그루트) 휴머노이드 기반 모델 훈련에 활용할 수 있습니다. 이러한 인프라는 향후 로봇 개발사들이 자체 AI를 손쉽게 학습시킬 수 있도록 지원하며, 엔비디아 GPU 클라우드 수요를 창출할 것입니다.

둘째, 실제 현장에서 로봇을 구동하는 엣지 AI 칩 플랫폼 공급자로서의 역할입니다. 휴머노이드 로봇 한 대마다 카메라를 통해 입력되는 영상 인식, 움직임 제어, 음성 인터페이스 등을 실시간으로 처리할 수 있는 AI 컴퓨팅 모듈이 필요합니다. 엔비디아는 과거 자율주행차용 Jetson/Orin 모듈 등 소형 AI 슈퍼컴퓨터를 개발한 경험을 바탕으로 휴머노이드 로봇용 차세대 모듈 또한 공급할 계획입니다. Financial Times 보도에 따르면, 엔비디아는 최근 "코스모스(Cosmos)" 플랫폼을 출시하며 휴머노이드 개발사들이 쉽게 사용할 수 있는 레퍼런스 컴퓨팅 모듈을 제공할 예정입니다. 만약 향후 수만 대에서 수백만 대의 휴머노이드 로봇이 생산된다면, 이는 엔비디아 칩셋 수백만 개 판매로 이어질 수 있는 거대한 잠재 시장이 될 것입니다.

상용화 속도와 난제: 휴머노이드 로봇의 보편화 시점에 대해서는 다양한 의견이 존재합니다. 기술적인 어려움(이족 보행 안정성, 배터리 지속 시간, 인간과의 안전한 상호 작용 등)이 많아 실제 생활에 투입되기까지는 최소 수년 이상의 시간이 더 필요하다는 의견이 있습니다. 실제로 테슬라 Optimus는 현재 간단한 부품 운반 작업 정도만 시연했으며, Boston Dynamics의 인간형 로봇 Atlas 또한 여전히 연구 개발 단계에 머물러 있습니다. 따라서 2025~2026년 단기적으로는 휴머노이드 로봇 시장이 엔비디아 실적에 크게 기여하기 어려울 수 있습니다. 그러나 노동력 부족 문제가 심각해지는 물류, 제조, 간병 등 분야에서 2030년 전후로 휴머노이드 로봇 도입이 본격화될 것이라는 전망 또한 높습니다. 엔비디아 Omniverse 담당 부사장 Rev Lebaredian은 "우리의 생활 환경은 사람을 기준으로 구축되었기 때문에 로봇 또한 휴머노이드 형태여야 한다"며 휴머노이드 로봇의 높은 범용성을 강조했습니다. 이처럼 산업계의 의지가 강하기 때문에 기술적인 장벽이 허물어지는 시점에 수요가 폭발적으로 증가할 수 있습니다. 엔비디아는 "유용한 범용 로봇을 만드는 데 필요한 마지막 요소는 AI 두뇌"라고 강조하며, AI 기술 성숙도가 로봇 보편화 시점을 결정짓는 중요한 요소가 될 것으로 보고 있습니다. 그리고 현재 AI 발전 속도를 고려할 때, 휴머노이드 로봇 시대가 멀지 않았다는 낙관적인 전망을 내놓고 있습니다.

엔비디아의 기회: 종합적으로 볼 때, Physical AI 분야는 중장기적인 성장 옵션으로서 엔비디아에게 매우 매력적인 기회입니다. 당장 현재 시점에서는 투자 비용(R&D)이 선행되지만, 5년 후 엔비디아가 로봇용 두뇌 시장에서 인텔과 같은 지위를 확보할 수 있다면 엄청난 규모의 새로운 매출원을 창출할 수 있습니다. 휴머노이드 로봇 한 대당 엔비디아의 고성능 모듈(수천 달러 규모)이 탑재되고, 로봇 학습 및 시뮬레이션 과정에서 GPU 클라우드 사용료가 발생한다면, 로봇 1대당 엔비디아의 평생 가치(LTV) 또한 상당할 것입니다. 더욱이 휴머노이드 로봇 시장은 엔비디아가 이미 개척해 놓은 자율주행차(Drive 플랫폼), 엣지 AI(Jetson) 사업과 시너지 효과를 낼 수 있습니다. 엔비디아는 이미 AI 소프트웨어 생태계(CUDA, Isaac SDK 등)를 통해 개발자 커뮤니티를 확보하고 있어 초기 시장 선점에 유리한 위치를 점하고 있습니다. 요약하자면, 휴머노이드 로봇의 보편화는 아직은 장기적인 시나리오이지만, 엔비디아에게 새로운 성장 동력을 제공할 잠재력이 매우 큰 기회라고 평가할 수 있습니다. 투자자들은 휴머노이드 로봇 분야의 기술 발전 및 시장 동향을 지속적으로 주시할 필요가 있습니다.

5. 투자 리스크 및 기회 요인 종합, 향후 주가 전망

지금까지 엔비디아를 둘러싼 경쟁 환경, 고객 투자 동향, 기술 혁신, 신규 시장 전망 등을 정량적인 데이터를 중심으로 분석했습니다. 이러한 분석을 바탕으로 단기 투자 결정에 영향을 미칠 수 있는 핵심 리스크와 기회 요인을 종합적으로 정리하고, 엔비디아 주가의 향후 움직임을 전망해 보겠습니다.

주요 리스크 요인:

① 경쟁 심화 및 고객사 이탈 가능성: 브로드컴, 마벨 등 경쟁사들의 맞춤형 ASIC 칩 시장이 성장하면서 일부 대형 고객사들이 엔비디아 GPU 수요를 줄일 수 있는 위험이 존재합니다. 예를 들어, AWS가 자체 Trainium 칩 채택 비중을 늘리거나, MS와 메타가 AMD GPU 또는 자체 개발 솔루션을 활용하여 일부 워크로드를 대체할 경우 엔비디아의 시장 점유율이 소폭 하락할 수 있습니다. 현재 엔비디아의 데이터센터 GPU 마진은 업계 최고 수준인데, 클라우드 서비스 업체들의 협상력이 강화됨에 따라 향후 GPU 가격 인하 압력이 발생할 가능성도 배제할 수 없습니다. 또한 AMD의 차세대 MI300 시리즈 GPU 출시 또한 제한적이지만 엔비디아에게는 경쟁 변수로 작용할 수 있습니다. 이러한 경쟁 심화는 엔비디아의 높은 수익성 유지가 지속 가능할지에 대한 의문을 제기할 수 있습니다.

② 기술 혁신 리스크: 앞서 DeepSeek 사례에서 살펴본 것처럼, AI 알고리즘 분야의 혁신적인 발전은 엔비디아 하드웨어 수요에 부정적인 영향을 미칠 수 있습니다. 향후 OpenAI 등 주요 AI 기업들이 모델 경량화 및 효율성 향상 기술을 적극적으로 도입할 경우 데이터센터에서 필요로 하는 GPU 수량이 감소할 수 있습니다. 또한 소프트웨어 최적화 기술(예: 모델 압축, 4bit/8bit 연산 등)을 통해 기존 GPU의 활용 효율성이 높아지면 신규 GPU 구매 수요가 둔화될 가능성도 있습니다. 이러한 기술 혁신의 불확실성은 엔비디아 주가에 변동성을 높이는 요인으로 작용할 수 있습니다. 2025년 1월 DeepSeek 이슈로 인해 엔비디아 주가가 하루 만에 -17% 급락했던 사례는 투자자들이 이러한 기술 혁신 리스크에 매우 민감하게 반응한다는 점을 보여줍니다.

③ 거시 경제 및 고객사 Capex 변동: 현재 빅테크 기업들의 Capex 증가는 엔비디아에게 긍정적인 영향을 미치고 있지만, 거시 경제 상황 변화에 따라 설비 투자 계획이 변동될 가능성 또한 존재합니다. 만약 경기 침체 우려가 현실화되어 기업들이 투자 규모를 축소하거나 투자를 연기할 경우, 고가의 AI 인프라 지출 또한 조정될 수 있습니다. 예를 들어, 금리 인상 기조가 지속되는 상황에서 2024~2025년 중 기술 기업들이 비용 절감을 더욱 강조하게 된다면 AI 투자 또한 일시적으로 위축될 수 있습니다. 최근 메타 등 일부 기업들은 AI 투자 확대 의지를 밝혔지만, 동시에 비용 효율화에 대한 압박도 받고 있습니다. 이처럼 Capex 사이클의 변동성은 엔비디아 실적에 직접적인 영향을 미치기 때문에 단기적으로 주가에 중요한 변수로 작용할 수 있습니다. (다만 현재까지는 2025년까지 주요 기업들이 AI 투자를 늘릴 것이라는 전망이 우세합니다.)

④ 규제 및 지정학적 위험: 미국의 대중국 수출 규제 강화로 인해 엔비디아는 A100/H100 GPU의 중국 수출이 제한되고 H800 등 다운그레이드된 제품만 판매하고 있습니다. 향후 미중 갈등이 더욱 심화되어 추가적인 제재가 가해지거나, 중국 경제가 둔화되어 중국 내 AI 수요가 감소할 경우 엔비디아의 매출에 부정적인 영향을 미칠 수 있습니다. 또한 엔비디아의 GPU 시장 지배력에 대한 반독점 규제 가능성 또한 잠재적인 위험 요인으로 작용할 수 있습니다. 현재까지는 엔비디아의 시장 지배력에 대한 경쟁사들의 불만이 제기되고 있지만, 아직까지 법적인 문제로 불거지지는 않은 상황입니다.

주요 기회 요인:

① 빅테크 AI 투자 확대 (단기 호황 지속): 2025년까지 빅테크 기업들의 AI Capex 투자 확대 추세가 지속될 것으로 예상됩니다. 마이크로소프트, 구글, 메타, 아마존 등 주요 빅테크 기업들이 AI 인프라 증설 경쟁을 벌이고 있어 엔비디아의 수주 파이프라인은 단기간 내에 매우 견고하게 유지될 전망입니다. 특히 엔비디아의 차세대 Blackwell GPU가 2024년 말에서 2025년 사이에 출시되어 기존 A100/H100 GPU를 사용하던 고객들의 업그레이드 수요를 자극할 경우 추가적인 매출 성장을 기대할 수 있습니다. 현재 엔비디아는 2년 치에 달하는 주문 잔고를 확보하고 있다는 보도도 있는 만큼, 단기적인 실적 가시성은 매우 높은 상황입니다.

② 제본스의 역설에 따른 AI 확산: AI 연산 비용이 감소하고 AI 서비스가 대중화될수록 AI 활용 분야가 기하급수적으로 확대되어 전체적인 AI 수요가 증가할 가능성이 높습니다. 예를 들어, 과거에는 AI 도입을 엄두도 내지 못했던 중소기업들도 이제는 클라우드 API를 통해 생성형 AI를 활용하기 시작했으며, 각 산업 분야별로 특화된 AI 모델 개발이 활발하게 진행되고 있습니다. 이러한 AI 수요 저변 확대는 엔비디아에게 수많은 중소 규모 고객층을 새롭게 창출해 주는 효과를 가져올 수 있습니다. 또한 자율주행차, IoT, AR/VR, 메타버스 등 인접 기술 분야와 AI가 융합되면서 엣지 컴퓨팅부터 클라우드 컴퓨팅까지 AI 솔루션 전반에 대한 수요가 증가하고 있습니다. 결국 "AI가 모든 곳에 사용되는 시대"가 도래하면 엔비디아 칩 또한 모든 곳에 사용될 가능성이 높아집니다. 현재 이러한 방향으로 시장이 발전하고 있으며, 엔비디아는 CUDA/X 기반의 소프트웨어 생태계를 통해 이러한 추세를 뒷받침하고 있습니다.

③ 신규 시장 창출 (로봇, 산업 AI 등): 앞서 언급한 Physical AI/로봇틱스 분야뿐만 아니라 의료 AI, 디지털 트윈, 국방 AI 등 새롭게 성장하는 시장에서 엔비디아 솔루션이 도입될 여지가 큽니다. 예를 들어, 의료 영상 AI 분석에는 고성능 GPU가 필수적으로 사용되며, 각국 군대의 AI 활용 증가(자율 드론 등)에도 엔비디아 기술이 적용될 수 있습니다. 특히 로봇틱스 분야에서 엔비디아는 시장 선도 기업으로서의 입지를 다지기 위해 노력하고 있으며, 중장기적으로 로봇틱스 시장은 엔비디아의 새로운 핵심 매출원이 될 수 있습니다. 이러한 구조적인 성장 요인은 엔비디아의 주가수익비율(PER)을 높은 수준으로 유지하는 데 기여할 수 있습니다.

④ 강력한 재무 실적과 현금 창출 능력: 엔비디아는 2023년 폭발적인 성장을 통해 막대한 현금 흐름을 확보했습니다. FY2024년(추정) 매출 500억 달러 중 상당 부분이 순이익으로 남을 것으로 예상되며, 현금 보유량 또한 크게 증가했습니다. 이는 향후 R&D 투자 여력을 확대하고 M&A를 통해 성장 동력을 확보할 수 있는 기반이 됩니다. 비록 2022년 ARM 인수 시도는 실패로 끝났지만, 향후 유망한 AI 스타트업이나 소프트웨어 기업 인수를 통해 사업 포트폴리오를 강화할 가능성이 있습니다. 풍부한 자본력을 바탕으로 기술 변화에 유연하게 대응할 수 있다는 점은 엔비디아 투자에 대한 안전판 역할을 합니다.

주가 전망 및 투자 평가:

엔비디아 주가는 2023년 한 해 동안 괄목할 만한 상승세를 기록하며 AI 랠리의 선두 주자로 자리매김했습니다. 현재 주가수익비율(PER)은 높은 수준이지만, 이는 2024~2025년의 높은 성장세(매출 및 이익 증가)를 선반영한 측면이 있습니다. Morgan Stanley 등 월가 주요 투자 은행들의 전망에 따르면, 엔비디아는 FY2025년에 매출 1,000억 달러, FY2026년에는 매출 1,950억 달러까지 성장할 것으로 예상됩니다. 만약 이러한 시장 컨센서스대로 엔비디아가 실적을 달성한다면 현재의 주가 고평가 논란은 자연스럽게 해소될 수 있을 것입니다.

단기적으로는 2024년 2월로 예정된 FY2024 4분기 실적 발표와 2025년 5월경에 발표될 1분기 실적이 중요한 주가 모멘텀으로 작용할 것입니다. 시장 예상치를 크게 상회하는 실적 성장세가 지속된다면 주가는 추가적으로 상승할 여지가 있습니다. 반대로, 데이터센터 GPU 주문 둔화 징후 등 부정적인 시그널이 나타날 경우에는 주가 조정이 발생할 수 있습니다. 최근 DeepSeek 이슈로 인해 엔비디아 주가가 급락했지만, 일주일 만에 주가가 회복되는 등 시장은 여전히 엔비디아의 펀더멘털에 대한 높은 신뢰를 유지하고 있음을 보여주었습니다. 엔비디아 또한 "AI 붐은 일시적인 현상이 아니다"라고 강조하고 있으며, 실제로 2024년에는 H100에서 Blackwell GPU로의 세대교체, Grace CPU 출하량 확대, 소프트웨어 수익 모델 강화 등 다양한 성장 촉매 요인이 존재합니다.

단기 투자 의견: 현재까지 확보된 정량적인 데이터들을 종합적으로 분석해 볼 때, 엔비디아의 단기적인 실적 모멘텀은 지속될 가능성이 높습니다. 경쟁사 현황, 주요 고객사들의 투자 계획, AI 시장 수요 등을 고려할 때 향후 1년 이내에 엔비디아의 매출과 이익은 높은 성장률을 유지할 가능성이 높습니다. 따라서 주가 또한 우상향 추세를 이어갈 가능성이 높지만, 이미 주가가 많이 상승한 만큼 중간중간 변동성이 확대될 수 있다는 점을 염두에 두어야 합니다. 특히 경쟁 심화, 기술 혁신 등과 관련된 이슈가 발생할 경우 주가가 일시적으로 급락할 수 있으므로, 단기 트레이딩 전략을 활용하는 투자자들은 이러한 이벤트 리스크에 주의해야 합니다.

종합 평가: 엔비디아는 AI 시대의 핵심적인 "필수재 공급 기업"으로 자리매김했으며, 현재로서는 위험 요인보다는 기회 요인이 더 많다고 판단됩니다. 객관적인 데이터 또한 이러한 분석을 뒷받침합니다. 향후 1~2년간 엔비디아는 실적 성장과 주가 상승이라는 긍정적인 흐름을 이어갈 것으로 예상되며, 단기적인 주가 조정 시에는 오히려 저가 매수의 기회로 활용할 수 있습니다. 투자자들은 경쟁사들의 움직임(브로드컴, 마벨 등), 주요 고객사들의 자체 칩 개발 진행 상황, 그리고 AI 시장 수요 관련 지표(데이터센터 투자 규모, 신규 AI 모델 트렌드 등)를 지속적으로 주시하면서 투자 포지션을 조절하는 전략을 세우는 것이 바람직해 보입니다. 결국 엔비디아에 대한 투자는 현시점에서 AI 산업의 성장에 대한 투자와 동일한 의미를 지니며, AI 시장의 지속적인 성장을 믿는 투자자라면 엔비디아 주식을 투자 포트폴리오에 일정 비중 포함하는 것을 고려해 볼 수 있습니다.

원본 글은 여기에 있습니다.

(원본 글에는 보고서의 주장에 대한 참고 문헌 링크까지 들어가 있습니다.)

https://chatgpt.com/share/67a32445-0844-800f-9d0d-3332c5c8eab7

https://www.oneusefulthing.org/p/the-end-of-search-the-beginning-of

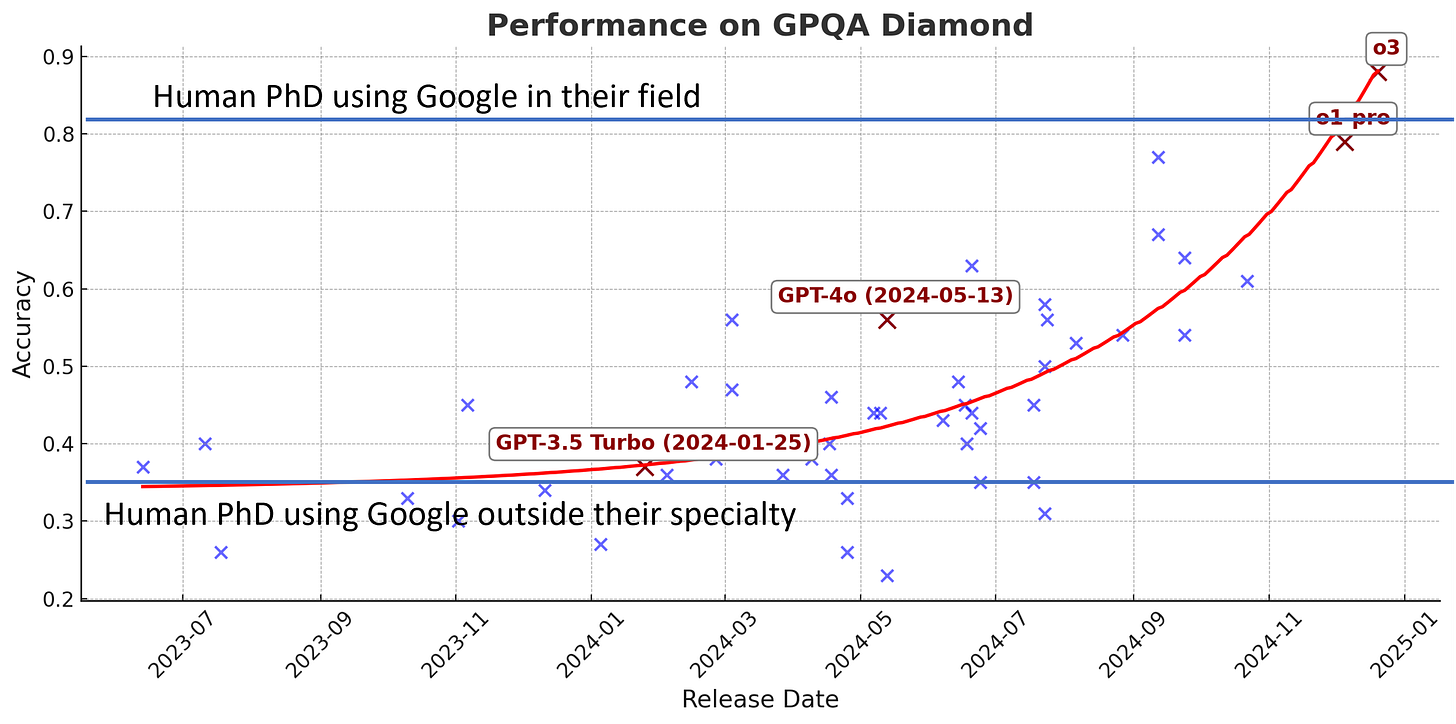

A hint to the future arrived quietly over the weekend. For a long time, I've been discussing two parallel revolutions in AI: the rise of autonomous agents and the emergence of powerful Reasoners since OpenAI's o1 was launched. These two threads have finally converged into something really impressive - AI systems that can conduct research with the depth and nuance of human experts, but at machine speed. OpenAI's Deep Research demonstrates this convergence and gives us a sense of what the future might be. But to understand why this matters, we need to start with the building blocks: Reasoners and agents.

Reasoners

For the past couple years, whenever you used a chatbot, it worked in a simple way: you typed something in, and it immediately started responding word by word (or more technically, token by token). The AI could only "think" while producing these tokens, so researchers developed tricks to improve its reasoning - like telling it to "think step by step before answering." This approach, called chain-of-thought prompting, markedly improved AI performance.

Reasoners essentially automate the process, producing “thinking tokens” before actually giving you an answer. This was a breakthrough in at least two important ways. First, because the AI companies could now get AIs to learn how to reason based on examples of really good problem-solvers, the AI can “think” more effectively. This training process can produce a higher quality chain-of-thought than we can by prompting. This means Reasoners are capable of solving much harder problems, especially in areas like math or logic where older chatbots failed.

The second way this was a breakthrough is that it turns out that the longer Reasoners “think,” the better their answers get (though the rate of improvement slows as they think longer). This is a big deal because previously the only way to make AIs perform better was to train bigger and bigger models, which is very expensive and requires a lot of data. Reasoning models show you can make AIs better by just letting them produce more and more thinking tokens, using computing power at the time of answering your question (called inference-time compute) rather than when the model was trained.

Because Reasoners are so new, their capabilities are expanding rapidly. In just months, we've seen dramatic improvements from OpenAI's o1 family to their new o3 models. Meanwhile, China's DeepSeek r1 has found innovative ways to boost performance while cutting costs, and Google has launched their first Reasoner. This is just the beginning - expect to see more of these powerful systems, and soon.

Agents

While experts debate the precise definition of an AI agent, we can think of it simply as “an AI that is given a goal and can pursue that goal autonomously.” Right now, there's an AI labs arms race to build general-purpose agents - systems that can handle any task you throw at them. I've written about some early examples like Devin and Claude with Computer Use, but OpenAI just released Operator, perhaps the most polished general-purpose agent yet.

The video below, sped up 16x, captures both the promise and pitfalls of general-purpose agents. I give Operator a task: read my latest substack post at OneUsefulThing and then go onto Google ImageFX and make an appropriate image, download it, and give it to me to post. What unfolds is enlightening. At first, Operator moves with impressive precision - finding my website, reading the post, navigating to ImageFX (pausing briefly for me to enter my login), and creating the image. Then the troubles begin, and they're twofold: not only is Operator blocked by OpenAI's security restrictions on file downloads, but it also starts to struggle with the task itself. The agent methodically tries every conceivable workaround: copying to clipboard, generating direct links, even diving into the site's source code. Each attempt fails - some due to OpenAI's browser restrictions, others due to the agent's own confusion about how to actually accomplish the task. Watching this determined but ultimately failed problem-solving loop reveals both the current limitations of these systems and raises questions about how agents will eventually behave when they encounter barriers in the real world.

Operator's issues highlight the current limits of general-purpose agents, but that doesn’t suggest that agents are useless. It appears that economically valuable narrow agents that focus on specific tasks are already possible. These specialists, powered by current LLM technology, can achieve remarkable results within their domains. Case in point: OpenAI's new Deep Research, which shows just how powerful a focused AI agent can be.

Deep Research

OpenAI’s Deep Research (not to be confused with Google’s Deep Research, more on that soon) is essentially a narrow research agent, built on OpenAI’s still unreleased o3 Reasoner, and with access to special tools and capabilities. It is one of the more impressive AI applications I have seen recently. To understand why, let’s give it a topic. I am specifically going to pick a highly technical and controversial issue within my field of research: When should startups stop exploring and begin to scale? I want you to examine the academic research on this topic, focusing on high quality papers and RCTs, including dealing with problematic definitions and conflicts between common wisdom and the research. Present the results for a graduate-level discussion of this issue.

The AI asks some smart questions, and I clarify what I want. Now o3 goes off and gets to work. You can see its progress and “thinking” as it goes. It is really worth taking a second to look at a couple samples of that process below. You can see that the AI is actually working as a researcher, exploring findings, digging deeper into things that “interest” it, and solving problems (like finding alternative ways of getting access to paywalled articles). This goes on for five minutes.

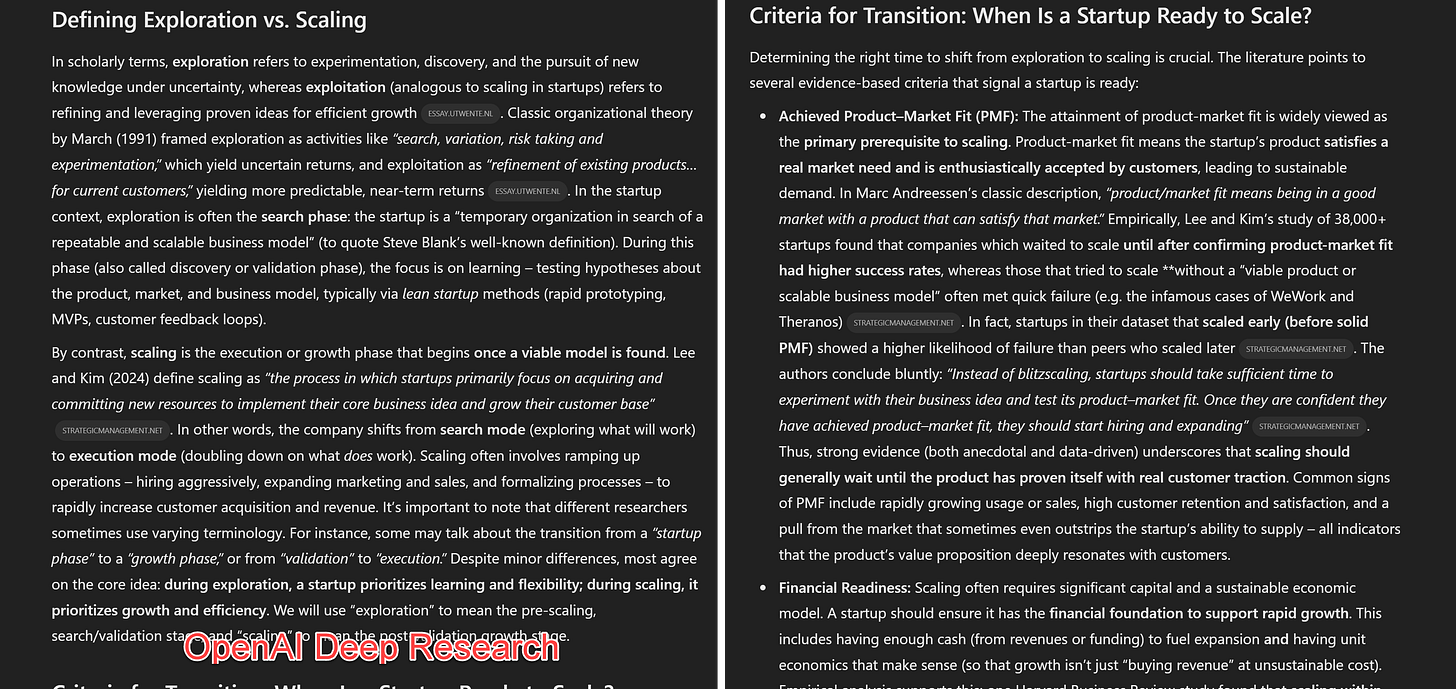

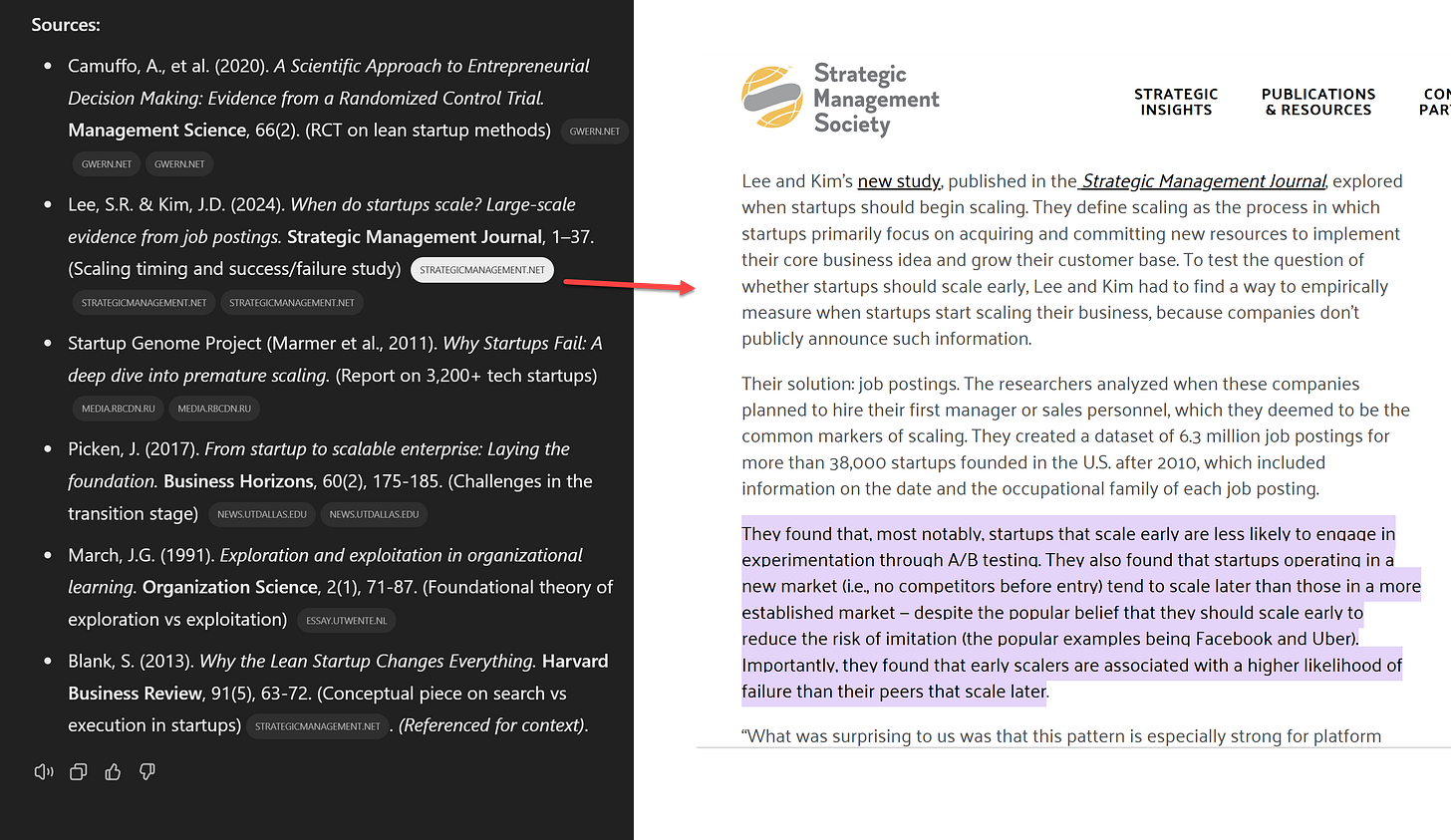

At the end, I get a 13 page, 3,778 word draft with six citations and a few additional references. It is, honestly, very good, even if I would have liked a few more sources. It wove together difficult and contradictory concepts, found some novel connections I wouldn’t expect, cited only high-quality sources, and was full of accurate quotations. I cannot guarantee everything is correct (though I did not see any errors) but I would have been satisfied to see something like it from a beginning PhD student. You can see the full results here but the couple excerpts below would suffice to show you why I am so impressed.

The quality of citations also marks a genuine advance here. These aren't the usual AI hallucinations or misquoted papers - they're legitimate, high-quality academic sources, including seminal work by my colleagues Saerom (Ronnie) Lee and Daniel Kim. When I click the links, they don't just lead to the papers, they often take me directly to the relevant highlighted quotes. While there are still constraints - the AI can only access what it can find and read in a few minutes, and paywalled articles remain out of reach - this represents a fundamental shift in how AI can engage with academic literature. For the first time, an AI isn't just summarizing research, it's actively engaging with it at a level that actually approaches human scholarly work.

It is worth contrasting it with Google’s product launched last month also called Deep Research (sigh). Google surfaces far more citations, but they are often a mix of websites of varying quality (the lack of access to paywalled information and books hurts all of these agents). It appears to gather documents all at once, as opposed to the curiosity-driven discovery of OpenAI’s researcher agent. And, because (as of now) this is powered by the non-reasoning, older Gemini 1.5 model, the overall summary is much more surface-level, though still solid and apparently error-free. It is like a very good undergraduate product. I suspect that the difference will be clear if you read a little bit below.

To put this in perspective: both outputs represent work that would typically consume hours of human effort - near PhD-level analysis from OpenAI's system, solid undergraduate work from Google's. OpenAI makes some bold claims in their announcement, complete with graphs suggesting their agent can handle 15% of high economic value research projects and 9% of very high value ones. While these numbers deserve skepticism - their methodology isn't explained - my hands-on testing suggests they're not entirely off base. Deep Research can indeed produce valuable, sophisticated analysis in minutes rather than hours. And given the rapid pace of development, I expect Google won't let this capability gap persist for long. We are likely to see fast improvement in research agents in the coming months.

The pieces come together

You can start to see how the pieces that the AI labs are building aren't just fitting together - they're playing off each other. The Reasoners provide the intellectual horsepower, while the agentic systems provide the ability to act. Right now, we're in the era of narrow agents like Deep Research, because even our best Reasoners aren't ready for general-purpose autonomy. But narrow isn’t limiting - these systems are already capable of performing work that once required teams of highly-paid experts or specialized consultancies.

These experts and consultancies aren't going away - if anything, their judgment becomes more crucial as they evolve from doing the work to orchestrating and validating the work of AI systems. But the labs believe this is just the beginning. They're betting that better models will crack the code of general-purpose agents, expanding beyond narrow tasks to become autonomous digital workers that can navigate the web, process information across all modalities, and take meaningful action in the world. Operator shows we aren’t there yet, but Deep Research suggests that we may be on our way.

Comments

Post a Comment